O MCP é um protocolo de comunicação criado pela Anthropic (proprietária do Claude.ai) que permite que clientes LLM executem capacidades de forma plug-and-play.

O quê?

A Forma Antiga

Pense em como criamos software de IA até agora. Vou usar um simples "LLM Wrapper" como exemplo. Uma empresa pode fazer integrações mais sofisticadas ou complexas usando múltiplos agentes, por exemplo, mas espero que você entenda meu ponto.

Nessa abordagem, tínhamos:

O Customer: A pessoa que paga para usar seus produtos ou serviços

Os Frontends: Os sistemas que entregam a experiência de IA ao cliente. Isso pode ser um serviço de mensagens conhecido como Facebook Messenger, Telegram, Slack, WhatsApp, seu próprio aplicativo ou site, ou qualquer outra coisa.

Os Conectors: Consistem em um ou mais componentes que preparam mensagens e chamam o LLM. Isso pode ser um provedor de integração parceiro, um serviço de software ou qualquer outra coisa que traduza as informações do "Frontend" em dados conhecidos pela empresa. O conector deve entender o frontend e traduzi-lo em informações úteis em ambas as direções. Cada frontend funciona de maneira diferente - Telegram e WhatsApp têm botões, o Slack tem comandos - e o conector lidará com essas diferenças.

O LLM Wrapper: Um ou mais componentes de software que preparam a mensagem e chamam o LLM. Este é o componente mais importante aqui; as outras partes já temos desde, não sei, os "bots inteligentes" em chamadas telefônicas ou antes disso até. Este componente deve lidar com pelo menos:

Prompt: Elaborar um bom prompt é importante para fazer as coisas funcionarem bem

Salvaguardas (Guardrails): Para evitar alguns erros, ações ruins, alucinações

Memória e Tamanho de Contexto: Para fornecer uma experiência adequada ao usuário

Rate-limit e Retentativas: Para experiência conversacional fluida, e lidando com os eventuais erros

Modelo: O custo vs benefícios; conhecer o melhor modelo para realizar suas tarefas é crucial

As Ferramentas (Tools) da Empresa: As ferramentas, às vezes chamadas de "function calls", são uma maneira do LLM acessar dados ou executar alguma ação fora do próprio LLM. Por exemplo, você pode ter uma ferramenta para "Editar nome de usuário do usuário", quando o LLM identifica o desejo do usuário de mudar seu nome de usuário, esta ferramenta será chamada. Ou você pode ter uma ferramenta de "Base de conhecimento" onde você coloca seu artigo de suporte do Zendesk; o LLM pode identificar uma pergunta do usuário e chamar esta ferramenta para encontrar informações. Posso explicar melhor em outra ocasião. É muito simples, e quando você entende, é como conhecer o segredo de um truque de mágica - você vai pensar "é só isso?"

Seu ecossistema empresarial: Os serviços, API, banco de dados, base de conhecimento..., qualquer integração com o sistema da sua empresa. Você não quer criar um simples chatbot; você precisa interagir com seu sistema para executar ações ou consultar dados.

Para construir esta arquitetura você deve:

Pagar pela conta do LLM (por exemplo, créditos da OpenAI)

Criar os prompts e ajustá-los para seus casos de uso

Garantir o modelo correto para o caso de uso específico

Lidar com limite de tokens, memória e sumarização

Construir ou comprar o conector (às vezes pagando pelo Frontend, WhatsApp por exemplo)

Construir as ferramentas (tools)

Aceitar o lock-in com um LLM. Apesar da compatibilidade da API e do modelo de comunicação ser relativamente simples, mudar de LLMs pode ser custoso ao tentar criar uma integração verdadeiramente agnóstica.

Cada LLM te dá "atalhos" (atalho = lock-in). Cada LLM, às vezes cada modelo, tem melhores práticas, e isso pode mudar a forma como você escreve seus prompts (prompt específico = lock-in)

Testar todos os componentes - E provavelmente pagar por isso

Agora que você entende a forma antiga, deve perceber que é assim que muitas empresas estão atualmente trabalhando com IA.

Eu construí sistemas assim para empresas. Claro, às vezes é mais simples, às vezes é mais difícil.

Existem frameworks, parceiros fornecedores, bancos de dados vetoriais, agentes, LLMs locais, SLM (modelos de linguagem pequenos) e mais. A ideia aqui foi fornecer uma visão de alto nível sobre como o cliente está conectado com um LLM, através da arquitetura da empresa.

A nova forma

Agora preciso explicar para você o que estou chamando de "nova forma". A mudança é drástica, mas torna as coisas mais simples.

Dada a arquitetura que mostrei anteriormente, qual é o componente mais importante da empresa? Você está certo se pensa que é o "Ecossistema da empresa" (e o frontend da empresa). Os outros componentes são apenas para dar ao usuário uma boa experiência de IA ou conversacional, certo?

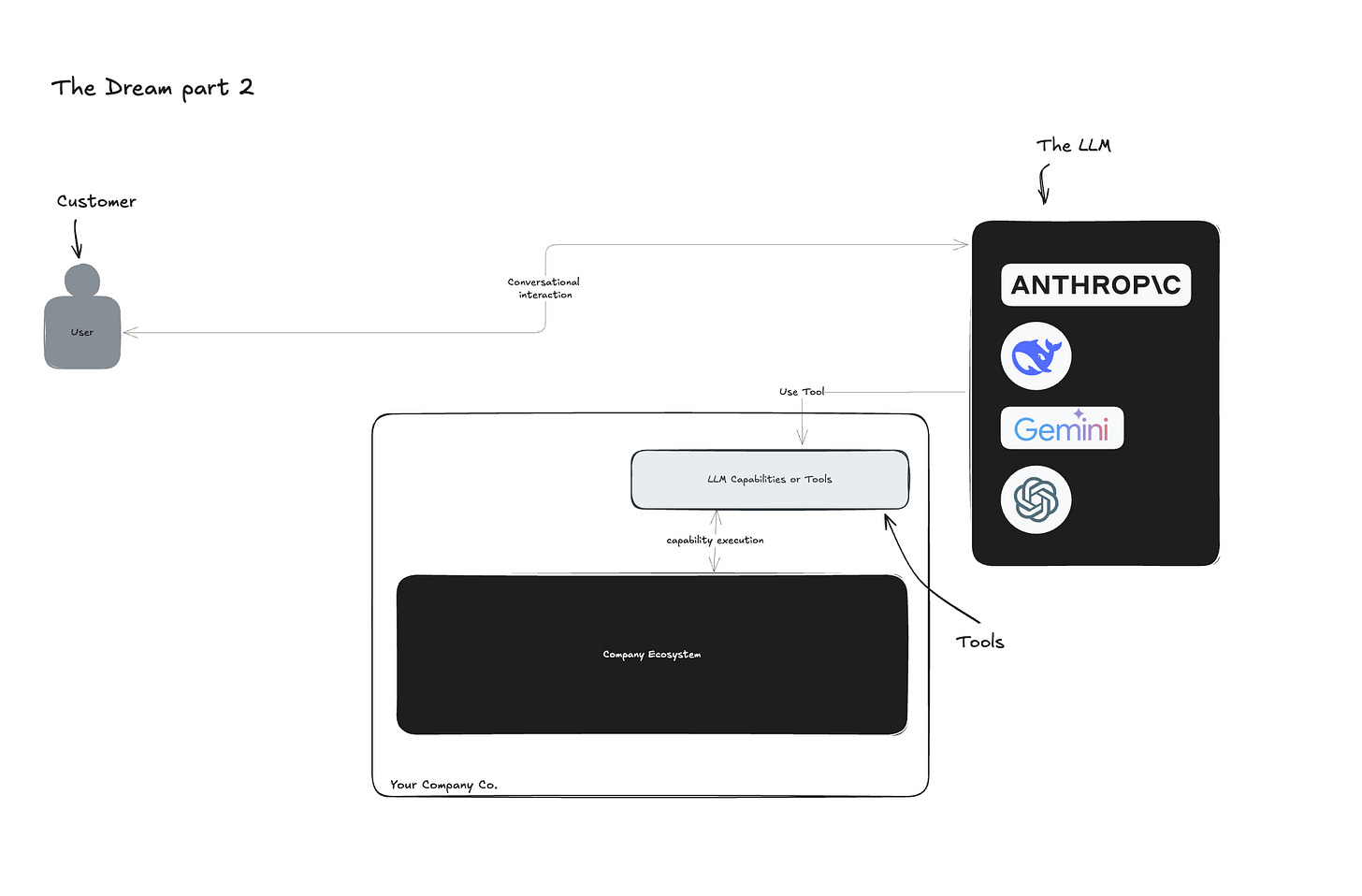

Imagine uma maneira em que as ferramentas da sua empresa estejam disponíveis para LLMs sem criar os Conectores com frontends ou qualquer tipo de wrapper! É um sonho!

Agora sobre os frontends: quem construiu, até agora, a melhor (e nativa) experiência conversacional? As empresas de LLM - OpenAI com ChatGPT, Anthropic com Claude, etc.

Não seria melhor se suas ferramentas estivessem disponíveis no ChatGPT, Claude, etc.? Sem nenhuma mensagem de grupo familiar distraindo seus clientes?

Agora apresento a você o MCP, o componente que faltava para tornar esse sonho realidade.

Como eu disse, o MCP é um "protocolo de comunicação que permite que clientes LLM executem capacidades de forma plug-and-play."

Deixe-me primeiro reformular a arquitetura e explicar os novos componentes:

- MCP Hosts: No meu exemplo, estes são os programas com os quais seu cliente interage - ChatGPT, Claude, o que estamos chamando de Clientes LLM.

- MCP Client: O programa que se conecta com os Servidores MCP - você pode construir um, mas é melhor usar um existente. Claude Desktop, Cursor e muitos outros MCP Hosts têm um Cliente MCP integrado.

- MCP Servers: O programa que expõe as capacidades ao MCP Client/MCP Hosts. Isso é o que eu chamei de "Ferramentas". Porém no MCP, os Servidores podem fornecer mais do que apenas ferramentas.

Essas três partes devem ter uma forma comum de comunicação, e este é o Protocolo de Comunicação de Modelo, ou MCP.

O MCP diz, por exemplo, como os MCP Hosts podem identificar ferramentas disponíveis, como os MCP Servers podem dizer quais informações o MCP Client deve enviar para as ferramentas serem executadas, e assim por diante.

O MCP é agnóstico em relação ao provedor; você não está preso a nenhum tipo de MCP Hosts. Se seu usuário está usando Claude ou Cursor, não importa - é o mesmo protocolo e funcionará da mesma maneira.

Agora vamos pensar nas consequências disso:

As capacidades da sua empresa estarão disponíveis em qualquer MCP Hosts (ChatGPT, Claude) - se este suportar MCP, você pode estar lá.

Você não paga por nenhum LLM - Sim, olhe para a imagem da arquitetura novamente. Você não chama mais o LLM, é o LLM que chama você.

O modelo depende do LLM que seu cliente usa - Seu cliente provavelmente já paga Claude ou ChatGPT para usar o melhor modelo disponível.

Você não se preocupa com prompts, guardrails, limites de contexto ou qualquer coisa assim - sua responsabilidade é fornecer ferramentas, e só isso. Você não é responsável por lidar com o chat ou sobre a conversa entre usuário ⇄ LLM.

Você não precisa criar ou comprar nenhum tipo de "conector" - o cliente usará os melhores aplicativos conversacionais e nativos que já existem.

Você só precisa testar suas ferramentas - A entrada e saída da ferramenta são definidas por você. Já temos maneiras de testá-las, e como é baseado em HTTP, você pode usar qualquer cliente HTTP. Você pode testá-lo com um terminal, um script Python, Postman ou qualquer ferramenta de teste HTTP bem conhecida.

O estágio atual - e como você pode testá-lo

Quando você pesquisa sobre MCP, duas coisas são importantes:

MCP Servers locais ou remotos

A propriedade do MCP Servers

Servidores MCP Locais vs Remotos

Até agora, meu objetivo foi mostrar como conectar sua empresa/aplicativo com essa nova tendência de IA. Basicamente, falamos sobre um MCP Servers remoto - o servidor MCP que você hospedará em seu servidor e exporá para seus clientes usarem.

Mas existem MCP Servers locais. Por exemplo, tenho um servidor MCP que roda no meu computador para dar ao Claude Desktop a capacidade de pesquisar, encontrar e editar meus arquivos, ou um servidore MCP que entende e conhece minhas notas do Obsidian. Local aqui é sobre a execução - tenho um servidor local MCP que se conecta com a API do Gmail e envia ou lê e-mails. Você vê a distinção? Um servidor local pode acessar recursos remotos, mas o importante é onde o servidor está rodando.

Hoje, a maioria dos servidores MCP são executados localmente, alguns construídos e entregues de maneiras que outras pessoas podem usar.

O método usual é usar npx (uma ferramenta Node.js para baixar, instalar e executar pacotes npm), ou uvx (uma ferramenta Python para baixar, instalar e executar pacotes Python).

A propriedade do Servidor MCP

Essa abordagem comum requer experiência mínima de desenvolvedor, o que é desafiador para usuários típicos, e requer que você conheça ou confie na pessoa que fez o servidor MCP.

Porque você dará a eles alguns acessos importantes (ao seu desktop ou conta de e-mail). Com isso em mente, tome cuidado com o que você usa.

"Repositório" de MCP

Hoje temos sites/ferramentas como Smithery com mais de 2000 servidores MCP que você já pode usar e testar.

Alguns são mais simples e dão ao LLM a capacidade de falar sobre o clima, enquanto outros aprimoram as capacidades de raciocínio do seu LLM Host com pensamento estruturado.

A mudança de jogo

A Microsoft chama isso de "Uma Mudança de Jogo na Integração de IA" — e eles estão certos.

Agora você entende um pouco melhor. Olhando para projetos como Smithery, imagine seu servidor MCP sendo usado junto com outros servidores MCP, onde seus clientes podem combinar capacidades.

Por exemplo, seu cliente pedirá para o Claude para buscar informações sobre algum recurso em sua empresa usando seu servidor MCP, depois usar as capacidades aprimoradas de raciocínio de um outro servidor MCP de pensamento estruturado para analisá-lo, e criar um relatório anual no Google Sheets usando outro servidor MCP - tudo em apenas uma frase, e sem mencionar nenhum nome de empresa, apenas falando sobre sua ideia.

Isso é diferente, isso é aberto, e espero que seja o futuro.

A seguir, quero te contar mais sobre isso e como fazer parte.

Com um simples texto eu acesso minhas notas do Obsidian, e enviou um resumo para um amigo no WhatsApp. Pense que poderia ter alguma capacidade da sua empresa no meio disso.